Nvidia im Höhenflug: Was Grafikchips mit dem KI-Boom zu tun haben

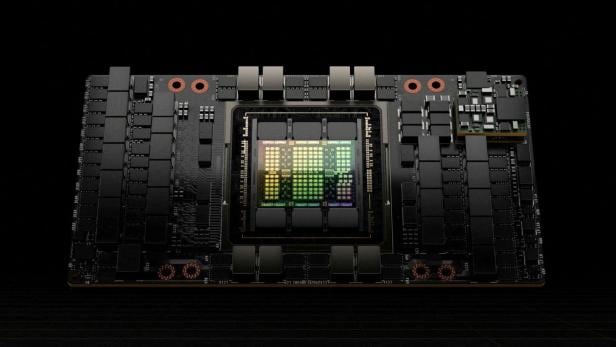

Nvidia H100

© via REUTERS / NVIDIA

B2B

Nvidias steiler Aufstieg wirft die Frage auf, warum der KI-Boom gerade dem GPU-Hersteller hilft. Wir erklären, was dahinter steckt.

Nvidia ist schlagartig an den großen Technologieunternehmen Microsoft, Google und Apple vorbeigezogen. Es ist jetzt das wertvollste Unternehmen der Welt.

Im Jänner war die Aktie des Unternehmens noch 45,05 Euro wert. Seither ging es steil nach oben bis zum aktuellen Spitzenwert von 129,66 Euro. Den Grund sehen Expertinnen vor allem im Hype um Künstliche Intelligenz. Doch warum sind gerade GPUs dafür entscheidend?

Viele verbinden Grafikkarten vor allem mit aufwendigen Computerspielen. Doch der Schein trügt, denn die darauf verbauten Grafikchips (GPUs) können viel mehr. „GPUs werden schon seit mehr als 15 Jahren nicht nur zum Gaming verwendet. Schon damals hat man erkannt, wie viel Rechenleistung sie bieten“, erklärt Ernst Haunschmid, Leiter des Fachbereichs High Performance Computing an der TU Wien, der futurezone.

➤ Mehr lesen: Wie Nvidia zum wertvollsten Unternehmen der Welt wurde

Parallelität ist gefragtDie GPUs müssen viele einzelne Pixel gleichzeitig auf einem Display darstellen können. Je besser die Darstellung von Spielen wurde, desto höher musste die Rechenleistung von GPUs werden, sagt Haunschmid.

Diese Parallelität ist inzwischen in vielen Bereichen essenziell. „Das findet auch in fast jedem Forschungsbereich Anwendung, in dem man Simulation betreibt.“ Kurzzeitig war das Schürfen von Kryptowährungen mit Grafikkarten ein großer Hype, jetzt ist es KI.

Künstliche neuronale Netze sind etwa ein wichtiger Teil von KI. Sie funktionieren wie Verbindungen im Gehirn. Auf einer Seite gibt es einen Startpunkt (das Eingabemuster) und auf der anderen Seite kommt ein Ausgabemuster heraus. Verbunden ist das durch viele künstliche Neuronen.

In der Trainingsphase eines KI-Modells werden die Verbindungen zwischen den einzelnen Neuronen laufend angepasst, neue Wege werden geschaffen und neu gewichtet, bis bei einer Eingabe eine gewünschte Ausgabe kommt. Bei einer Bilderkennung soll z.B. das Bild eines Apfels zum Wort "Apfel" führen und nicht zum Wort "Banane". Kommt bei einer Eingabe ein falsches Ergebnis heraus, muss der Weg so lange angepasst werden, bis er zum richtigen Ergebnis führt.

CPU vs. GPUHierfür eignen sich GPUs besonders gut, da sie alle diese Prozesse gleichzeitig verarbeiten können. Nun fragt man sich zurecht, warum man gerade einen Grafikchip nutzt, wenn es doch gar nichts grafisch darzustellen gibt. Stattdessen könnte doch auch das Gehirn eines Computers, die CPU (zentrale Recheneinheit), dafür benutzt werden. Doch sie verarbeitet, im Gegensatz zur GPU, Aufgaben nacheinander. "CPUs sind Generalisten. Sie können rechnen, Daten bewegen und I/O-Operationen auf Datenträgern machen", so Haunschmid.

➤ Mehr lesen: Nvidia präsentiert den "weltweit stärksten Chip"

CPUs und GPUs besitzen Kerne, auf die Aufgaben verteilt und damit auch schneller erledigt werden. Damit der Computer präzise funktioniert, ist das entscheidend. CPUs gibt es derzeit mit bis zu 128 Kernen. Nvidias Flaggschiff-GPU für Industrieanwendungen, die H100, hat 14.592 Kerne, die spezielle Aufgaben sehr schnell abarbeiten.

Ein Experiment der Mythbusters demonstriert den Unterschied zwischen CPU und GPU sehr deutlich:

Doch warum konnte Nvidia sich mit so großem Abstand zum klaren Marktführer hocharbeiten? Ein Grund ist ohne Frage die hohe technische Qualität ihrer Produkte. Doch auch ihre Preispolitik spielt eine wichtige Rolle.

Ihre aktuell beste Gaming-Grafikkarte, die GeForce RTX4090, kostet derzeit 1.779 Euro und könnte mit 16.384 Kernen zumindest auf den ersten Blick auch ein Kandidat für KI-Anwendungen sein. Doch Nvidia hat aber bereits vor Jahren den Einsatz von Konsumentenkarten der GeForce-Reihe in Datencentern in seinen Nutzungsbedingungen ausgeschlossen.

Das bestätigt auch Haunschmid, der erklärt, dass Nvidia eine technische Bremse eingebaut hat, die den Einsatz der Gaming-Karten für Industriezwecke verhindert. Eine ähnliche Praktik gab es schon beim Bitcoin-Mining. Der Grund dafür könnte offensichtlicher nicht sein: „Es gibt zu den professionellen Karten einen erheblichen Preisunterschied“. Die H100 kostet zwischen 30.000 und 40.000 Euro.

Hunderttausende GPUs für Meta und MicrosoftGroße Unternehmen brauchen nicht eine, sondern Hunderttausende GPUs. Laut Schätzung der Analysten von Omdia Research (via Statista) hat Nvidia 2023 je 150.000 H100-GPUs an Microsoft und Meta ausgeliefert. 50.000 Chips gingen jeweils an Tencent, Oracle, Amazon und Google.

➤ Mehr lesen: Nvidia: Krypto hat keinen Nutzen für die Gesellschaft

Die professionellen GPUs sind durch spezifische Software und Hardware explizit für den Einsatz in der Industrie optimiert. Mit CUDA hat Nvidia eine eigene Schnittstelle geschaffen, mit denen die Prozesse auf seinen GPUs noch beschleunigt werden.

Ebenfalls entscheidend ist eine hohe Memory-Bandweite, mit der die Profi-GPU gleichzeitig auf viele Daten zugreifen kann. Das ist für KI-Anwendungen unverzichtbar, wo Eingaben mit Datenbankeinträgen abgeglichen werden müssen, um schnell das gewünschte Ergebnis zu liefern.

"Dominanz wird dieses Jahr noch anhalten"Nvidia hat es durch die jahrelange Arbeit an diesem Komplettsystem - bestehend aus GPU, Schnittstellen und Software - geschafft, eine technische Basis für KI-Nutzung zu bieten, die ihresgleichen sucht. Laut Haunschmid ist vor allem die Software der Grund für Nvidias Erfolg: „Für andere Firmen wird es schwierig zu überzeugen. Nvidias Dominanz wird dieses Jahr noch anhalten.“ Diese Marktdominanz zeigt sich bei der H100: Wer jetzt die GPU kaufen will, muss mit Wartezeiten von über einem Jahr rechnen.

Doch auch für andere Firmen ist das Geschäftsfeld weiterhin interessant, wenn sie technisch aufschließen. Daran sind die größten Konkurrenten AMD und Intel bisher gescheitert.

AMD greift derzeit mit Dumping-Preisen für seine leistungsstarke KI-GPU MI300X an. Sie geht für 15.000 bis 20.000 Euro über den Tisch. Doch obwohl sie die H100 übertreffen soll, ist das Nvidia-System stabiler, verlässlicher und verbreiteter. Es dürfte aber nur eine Frage der Zeit sein, bis AMD den Nvidia-Höhenflug zumindest bremsen kann.

Interessant wird es auch, wenn sich der KI-Einsatz weiter etabliert. Denn für die Trainingsphase, die aktuell die meiste Leistung erfordert, braucht es andere Prozessoren als für die sogenannte Interferenz-Phase.

In dieser wird das bereits trainierte Modell mit neuen Daten gefüttert, um eine Aufgabe zu lösen. „Hier müssen Sprachmodelle in einem riesigen Datenspeicher das genau passende Stück finden“, erklärt Haunschmid. Neben den großen Firmen arbeiten auch Start-ups mit Hochdruck daran, spezielle KI-Prozessoren nur für diesen Einsatz zu entwickeln.